Guia de início rápido da API de raspagem da Web

Mihnea-Octavian Manolache em 14 Jul 2023

A WebScrapingAPI oferece um conjunto de soluções de raspagem da Web. O nosso principal produto é um web scraper de uso geral, concebido para recolher dados em tempo real de qualquer sítio Web. Como descobrirá ao longo deste guia, a ferramenta está repleta de várias funcionalidades, o que lhe permite não ser detectada pelos sistemas anti-bot. Com um vasto conjunto de funcionalidades, este guia foi concebido para o ajudar a começar a utilizar a Web Scraping API. Aqui estão alguns dos detalhes que iremos abordar:

- Trabalhar com o painel de controlo de front-end

- Compreender os parâmetros e as funcionalidades da API

- Envio de pedidos básicos para a API

- Configurar um web scraper complexo utilizando os SDKs

Porquê registar-se com a API de Web Scraping

Existem inúmeras razões para utilizar a API de Web Scraping em vez de um scraper normal. No entanto, estamos a contar com o feedback para decidir o que faz de nós a melhor escolha. E aqui estão algumas das razões pelas quais os nossos clientes nos escolheram:

- Suporte profissional - O nosso suporte é coberto por engenheiros de software reais que trabalham com a API. Assim, quando nos pede ajuda, certificamo-nos de que obtém as melhores respostas possíveis. Além disso, se encontrar algum problema, o engenheiro que está a falar consigo provavelmente conseguirá resolvê-lo em pouco tempo e colocá-lo em produção.

- Facilidade de utilização - Construir um raspador da Web pode ser um desafio. É necessário ter em conta vários proxies, evasões, captchas, browsers, etc. Com a Web Scraping API, obtém tudo isso (e muito mais) com um "clique de um botão".

- Escalabilidade - Quando construímos o nosso produto, uma das nossas primeiras prioridades foi garantir que apresentamos resultados independentemente do número total de pedidos que estamos a receber. Quando se inscreve na Web Scraping API, inscreve-se em toda a nossa infraestrutura. E isso inclui proxies, browsers, clientes HTTP e muito mais.

Inscrição para um Scraper gratuito baseado na nuvem

Para se registar na Web Scraping API, só é necessário um endereço de correio eletrónico válido. Além disso, cada utilizador tem direito a uma avaliação gratuita de 7 dias com acesso total às funcionalidades da API, limitada a 1000 créditos API. Após estes 7 dias, continua a ter acesso a um nível gratuito, que lhe oferece 1000 créditos API por mês, mas com funcionalidades API limitadas. Se quiser continuar a utilizar a versão completa do nosso web scraper baseado na nuvem, oferecemos-lhe planos de preços flexíveis. Pode consultar a página de preços para obter informações actualizadas sobre os preços. Em resumo, oferecemos:

- um plano Starter, com um máximo de 100 000 créditos API e 20 chamadas em simultâneo

- um plano Grow, com até 1.000.000 de créditos API e 50 chamadas simultâneas

- um plano Business, com até 3.000.000 créditos API e 100 chamadas simultâneas

- um plano Pro, com um máximo de 10 000 000 créditos API e 500 chamadas simultâneas

- um plano empresarial personalizado que será discutido com base nas suas necessidades específicas

Para começar, visite a nossa página SigUp aqui e crie simplesmente uma conta gratuita.

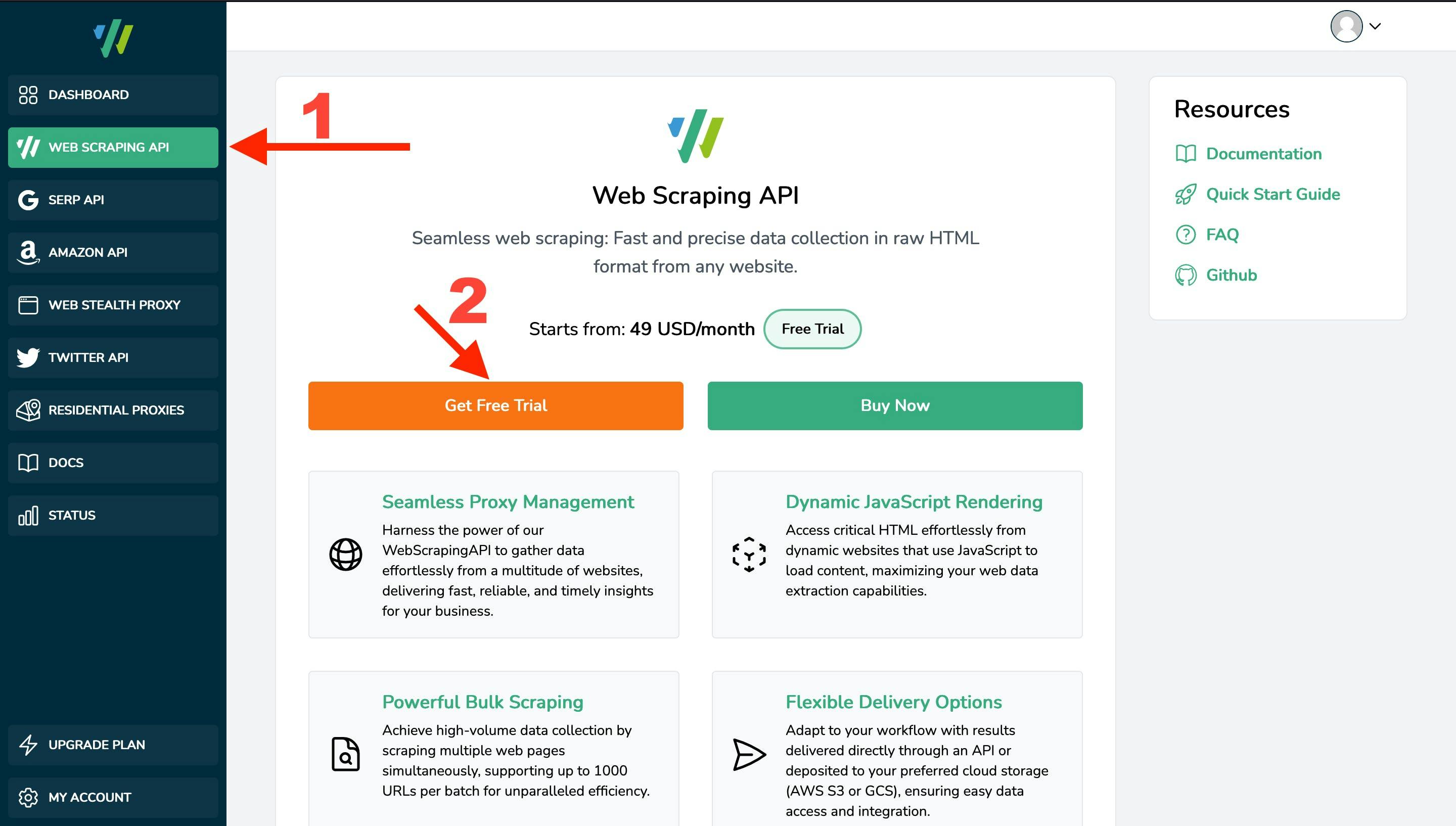

Compreender o painel de controlo

O facto de se inscrever no nosso Painel de Controlo não lhe dá implicitamente acesso aos nossos produtos. Como pode ver, a barra lateral esquerda apresenta algumas opções, associadas aos nossos produtos. Uma vez que este guia se refere ao Web Scraper de uso geral, para criar uma subscrição para este serviço, navegue até Web Scraping API e clique no botão "Get Free Trial". Depois que a assinatura for criada, você receberá uma chave de API. Certifique-se de que a guarda em segurança, uma vez que será o seu identificador único nos nossos sistemas. Poderá então aceder à página de estatísticas e ao Playground.

Noções básicas da nossa API Web Scraper

Existem três formas de interagir com o nosso web scraper, duas das quais são, digamos, "programáticas" e uma que é mais "amigável para principiantes". As duas primeiras implicam aceder à API através de clientes HTTP ou através dos nossos SDKs. O terceiro é usar o Playground fornecido dentro do Dashboard. Iremos abordá-los em breve, mas antes disso, é importante compreender como funciona a API. Só então você poderá usar todo o poder da API de Web Scraping. Portanto, vamos começar com o básico:

Autenticação de pedidos

A forma como autenticamos os pedidos provenientes de utilizadores registados é activando o parâmetro de URL `api_key`. A chave API única está associada à sua conta e contém informações sobre permissões, utilização, etc.

Tenha em atenção que cada produto em que se inscreve tem uma chave de API exclusiva associada. Por exemplo, não pode utilizar a chave API do seu raspador Web de uso geral na API SERP ou vice-versa.

Dito isto, para extrair um URL como um utilizador autenticado, terá de aceder ao seguinte recurso:

https://api.webscrapingapi.com/v1?api_key=<YOUR_UNIQUE_API_KEY>

Parâmetros da API

Na nossa API, os parâmetros de consulta são utilizados para personalizar o raspador com base nas suas necessidades. Compreender como cada parâmetro funciona permitir-nos-á utilizar todo o poder da nossa API de raspagem da Web. Mantemos uma documentação actualizada dos parâmetros da API aqui. No entanto, também vamos mergulhar neles aqui, para ter uma melhor compreensão de como os parâmetros de consulta funcionam com a API de raspagem da Web. Dito isso, há três tipos de parâmetros: obrigatórios, padrão e opcionais. Os obrigatórios são bastante simples:

- O parâmetro `api_key` que discutimos acima

- O parâmetro `url`, que representa o URL que pretende extrair

Tenha em atenção que o valor do parâmetro `url` deve ser um URL válido, não um nome de domínio, e que, idealmente, deve ser codificado por URL. (ou seja, https%3A%2F%2Fwebscrapingapi.com)

No que diz respeito aos parâmetros predefinidos, utilizámos dados históricos para aumentar a taxa de sucesso da nossa API (e, implicitamente, a do seu projeto). Os dados internos mostram que a melhor configuração para a recolha de dados da Web é utilizar um navegador da Web real emparelhado com um endereço IP residencial. Por isso, os parâmetros predefinidos da nossa API são:

- `render_js=1`- para ativar um browser real (não um cliente HTTP básico)

- `proxy_type=residential`- para aceder ao alvo através de um endereço IP residencial (ativado apenas se o seu plano atual suportar proxies residenciais)

Naturalmente, também pode substituir o valor destes parâmetros, embora não o encorajemos. A recolha de dados com um cliente HTTP básico e proxies de centros de dados leva normalmente a que o sítio Web alvo detecte a atividade de recolha de dados e bloqueie o acesso.

A seguir, vamos discutir os parâmetros opcionais. Uma vez que documentámos todos os parâmetros na nossa Documentação, vamos apenas discutir os parâmetros mais utilizados por agora:

- Parâmetro: render_js

Descrição: Ao ativar este parâmetro, acederá ao URL visado através de um browser real. Tem a vantagem de renderizar ficheiros JavaScript. É uma ótima opção para raspar sites com muito JavaScript (como aqueles criados com ReactJS, por exemplo).

Documentação:[aqui] - Parâmetro: proxy_type

Descrição: Utilizado para aceder ao URL visado através de um endereço IP residencial ou de um centro de dados.

Documentação:[aqui] - Parâmetro: stealth_mode

Descrição: A raspagem da Web não é uma atividade ilegal. No entanto, alguns sítios Web tendem a bloquear o acesso a software automatizado (incluindo web scrapers). A nossa equipa concebeu um conjunto de ferramentas que torna quase impossível que os sistemas anti-bot detectem o nosso Web scraper. Pode ativar estas funcionalidades utilizando o parâmetro stealth_mode=1.

Documentação:[aqui] - Parâmetro: country

Descrição: Utilizado para aceder ao seu alvo a partir de uma localização geográfica específica. Verificar os países suportados [aqui].

Documentação:[aqui]. - Parâmetro: timeout

Descrição: Por defeito, terminamos um pedido (e não cobramos se falhar) após 10s. Com determinados objectivos, poderá querer aumentar este valor até 60s.

Documentação:[aqui] - Parâmetro: device

Descrição: Pode utilizar isto para fazer com que o seu raspador se pareça com um 'desktop', 'tablet' ou 'telemóvel'.

Documentação:[aqui] - Parâmetro: wait_until

Descrição: Em termos simples, quando atinge o URL alvo, congela o scraper até que um determinado evento aconteça. O conceito que seguimos é melhor descrito [aqui].

Documentação:[aqui]. - Parâmetro: wait_for

Descrição: Este parâmetro congela o raspador durante um determinado período de tempo (que não pode exceder 60s).

Documentação:[aqui] - Parâmetro: wait_for_css

Descrição: Congela o scraper até que um determinado seletor CSS (ou seja, classe ou ID) esteja visível na página.

Documentação:[aqui] - Parâmetro: session

Descrição: Permite-lhe utilizar o mesmo Proxy (endereço IP) em vários pedidos.

Documentação:[aqui]

Códigos de resposta

Um dos aspectos mais importantes que tem de saber sobre os códigos de resposta é que só cobramos por respostas bem sucedidas. Portanto, se o seu pedido resultar em algo diferente do código de estado 200, não será cobrado. Para além disso, os erros da API estão documentados aqui e, como verá, seguem os códigos de estado HTTP normais. Para citar alguns:

- 400: Bad Request - Quando se enviam parâmetros inválidos, por exemplo

- 401: Não autorizado - Quando não é possível enviar uma `api_key` ou a chave da API é inválida

- 422: Entidade não processável - Quando a API não consegue satisfazer o pedido (por exemplo, quando o seletor CSS que esperava não está visível na página)

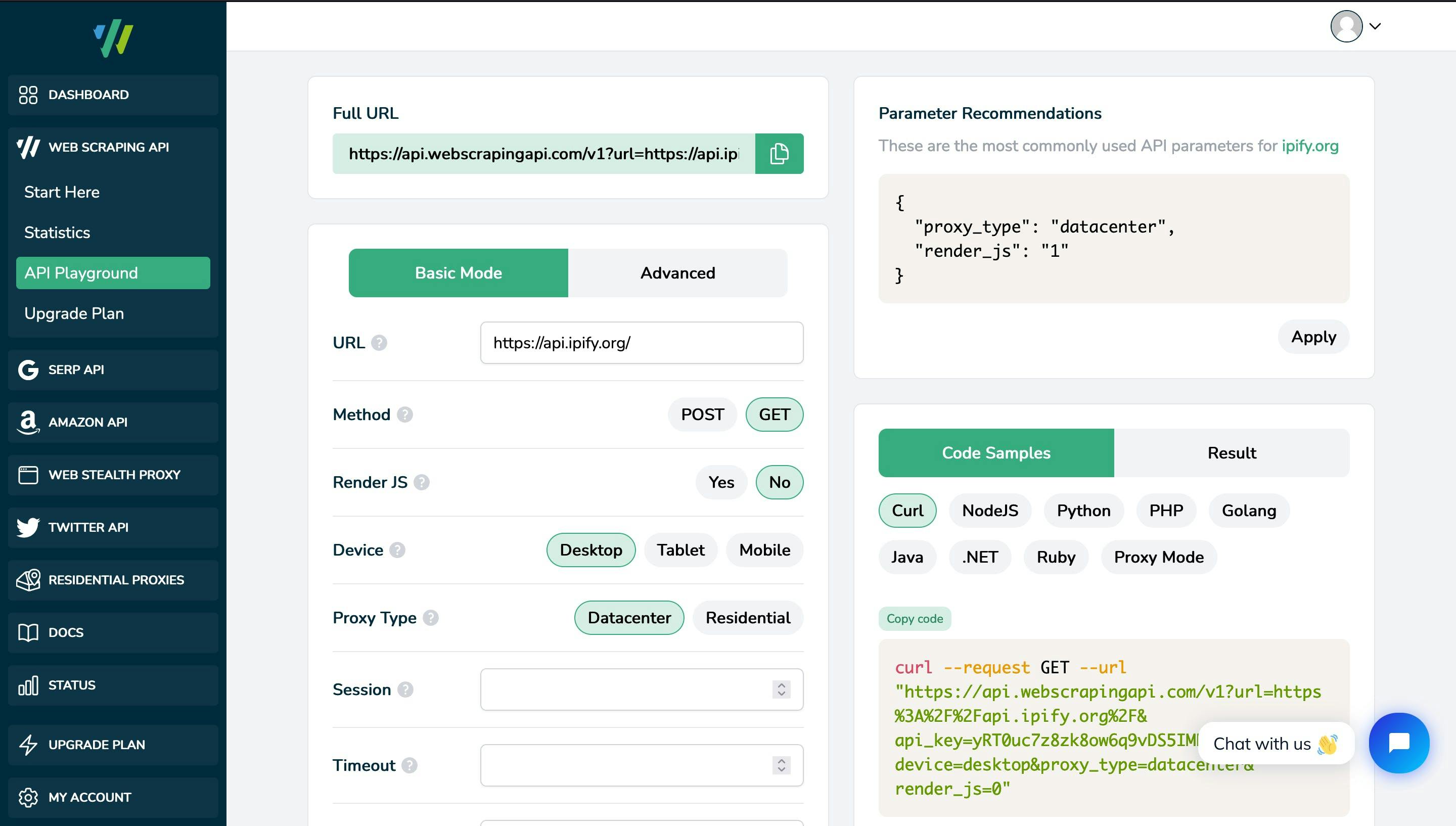

Interagir com a API do Web Scraper

Como já foi dito, existem principalmente três formas de interagir com a API do Web scraper. Em primeiro lugar, utilizar os SDKs ou aceder à API através de clientes HTTP depende mais da linguagem (ou tecnologia) e requer alguns conhecimentos técnicos. Uma interface mais amigável para principiantes está disponível no nosso Dashboard, no API Playground. Esta ferramenta permite-lhe brincar com o nosso web scraper, testá-lo e perceber como utilizar os parâmetros em seu benefício, antes de avançar para implementações programáticas ou funcionalidades avançadas. Alguns dos principais aspectos do playground são:

- Corrige automaticamente as incompatibilidades de parâmetros (por exemplo, `stealth_mode=1` é incompatível com `render_js=0`)

- Fornece exemplos reais de código para várias linguagens de programação que pode utilizar no seu projeto

- Apresenta os parâmetros recomendados, com base nos nossos testes internos e nos dados históricos de pedidos anteriores, para que possa aumentar a taxa de sucesso do seu projeto

Funcionalidades avançadas de Web Scraping

Para utilizadores avançados, a nossa API está repleta de várias funcionalidades, o que a torna personalizável e pronta para qualquer projeto de raspagem. Mais uma vez, uma boa fonte de informação é a nossa documentação oficial. No entanto, aqui estão alguns dos aspectos que devemos destacar:

POST, PUT e PATCH

Com a API de recolha de dados da Web, não está obrigado a utilizar apenas pedidos GET. Se o seu projeto de recolha de dados precisar de criar, substituir ou atualizar recursos, pode utilizar os nossos pedidos POST, PUT ou PATCH. Um aspeto fundamental destes pedidos é que também pode utilizar `render_js=1`, o que significa um navegador Web real e não um simples cliente HTTP. Um exemplo de pedido POST é:

curl --request POST --url "https://api.webscrapingapi.com/v1?api_key=<YOUR_API_KEY>&url=https%3A%2F%2Fhttpbin.org%2Fpost" --data "{

"foo": "bar"

}"Modo Proxy

Também pode utilizar a nossa API como um proxy para recolher o seu URL alvo. Para aceder à API como um proxy, é necessário ter em conta o seguinte:

- O nome de utilizador para autenticar com o proxy é sempre definido como `webscrapingapi`, seguido dos parâmetros que pretende ativar, separados por pontos.

- A palavra-passe é sempre a sua chave API pessoal

Eis um exemplo de url que pode utilizar para aceder ao web scraper através do nosso Modo Proxy:

https://webscrapingapi.<parameter_1.parameter_2.parameter_n>:<YOUR_API_KEY>@proxy.webscrapingapi.com:8000

Conclusões

A Web Scraping API oferece um conjunto de ferramentas de raspagem poderosas, apoiadas por uma equipa de engenheiros e prontas a utilizar. Está repleta de dezenas de funcionalidades, o que a torna uma solução de raspagem da Web personalizável. Além disso, pode integrar o raspador web de uso geral na nuvem com qualquer linguagem ou tecnologia de programação, uma vez que devolve HTML em bruto ou JSONs analisados. Além disso, a nossa extensa documentação e os repositórios públicos do GitHub devem ajudá-lo a começar o seu projeto num instante.

Esperamos que este guia seja um bom ponto de partida para si e note que o nosso apoio está sempre disponível se tiver alguma dúvida. Esperamos ser o seu parceiro no sucesso!

Notícias e actualizações

Mantenha-se atualizado com os mais recentes guias e notícias sobre raspagem da Web, subscrevendo a nossa newsletter.

Preocupamo-nos com a proteção dos seus dados. Leia a nossa Política de Privacidade.

Artigos relacionados

Faça scraping da Amazon de forma eficiente com a solução económica da Web Scraping API. Aceda a dados em tempo real, desde produtos a perfis de vendedores. Registe-se agora!

Recolha sem esforço dados em tempo real dos motores de busca utilizando a API SERP Scraping. Melhore a análise de mercado, SEO e pesquisa de tópicos com facilidade. Comece hoje mesmo!

Explore o poder transformador da recolha de dados da Web no sector financeiro. Desde dados de produtos a análises de sentimentos, este guia oferece informações sobre os vários tipos de dados da Web disponíveis para decisões de investimento.