Proxies rotativos: Tudo o que precisa de saber

Raluca Penciuc em Jan 08 2023

Quando começou a aprender as bases do web scraping, teve um momento de "oh bolas, vou precisar de proxies para isto"? Bem, prepare-se para ter esse tipo de epifania outra vez, porque os proxies rotativos são o nível seguinte na funcionalidade de recolha de dados da Web.

Não acredita em mim? Vejamos os benefícios que os proxies trazem se não os rodar e depois as vantagens extra que obtém com a rotação. Eis o que os IPs não rotativos trazem:

- Pode repetir a recolha de dados de uma página/sítio Web depois de o IP inicial ter sido bloqueado.

- Pode mudar manualmente os endereços para ultrapassar os sítios Web que utilizam a geolocalização para restringir o conteúdo.

- Não se dá a conhecer a localização real.

- Ao adicionar um atraso no pedido, pode extrair dados de sítios Web com contramedidas anti-raspagem.

Estas são, sem dúvida, coisas boas de se ter, mas vejamos o que acontece quando se acrescenta um novo toque (trocadilho intencional):

- O "scraper" envia continuamente pedidos até conseguir obter as informações de que necessita.

- Pode aceder facilmente a conteúdos com restrições geográficas a partir de qualquer país onde tenha um proxy.

- Os sítios Web nem sequer sabem que os bots os estão a visitar.

- Pode obter dados de qualquer sítio Web sem ter de abrandar os pedidos.

Isto é apenas um resumo rápido das diferenças, mas é bastante impressionante, não é? Vamos então mergulhar e aprender como é que estes benefícios surgem!

O que são proxies rotativos?

Por proxies rotativos, entendemos o processo de mudar automaticamente de um IP para outro com cada pedido enviado. Em teoria, isto pode ser feito manualmente, mas isso significaria que não poderia colocar em fila de espera uma lista de URLs para raspagem. Em vez disso, teria de atribuir um proxy, enviar um pedido, atribuir outro proxy, enviar outro pedido, e assim por diante. Espero que perceba como isso seria ineficiente.

Para a rotação automática de proxy, é necessário um novo intermediário, um proxy para o seu proxy, se preferir. Este novo intermediário é um servidor que tem acesso a todo o seu conjunto de proxies. Assim, em vez de procurar na lista de IPs, o servidor faz isso por si. Tudo o que tem de fazer é dar-lhe o comando.

Aqui está um resumo do processo de raspagem com um programa que roda proxies:

- O utilizador envia um pedido ao servidor de gestão de proxy.

- O servidor escolhe um proxy aleatoriamente (exceto se especificado em contrário) e envia-lhe o pedido.

- O proxy envia então o pedido para o alvo final, a página Web com os dados a extrair.

- A resposta segue o mesmo caminho de volta para o utilizador.

Estes quatro passos são repetidos até que o utilizador tenha toda a informação que pretende. Cada pedido passa por um novo proxy, simulando as acções de muitos utilizadores diferentes que se ligam a um sítio Web.

Assim, na sua essência, os proxies rotativos não requerem trabalho extra da sua parte. Essa é a beleza da coisa. É mais automação para uma ferramenta que já está destinada a recolher toneladas de informação sem esforço do utilizador.

Claro que, para a rotação de IPs, é necessário, antes de mais, um conjunto de proxies. No entanto, como nem todos os proxies são iguais, também precisa de reunir os IPs certos. Aqui estão os dois principais concorrentes:

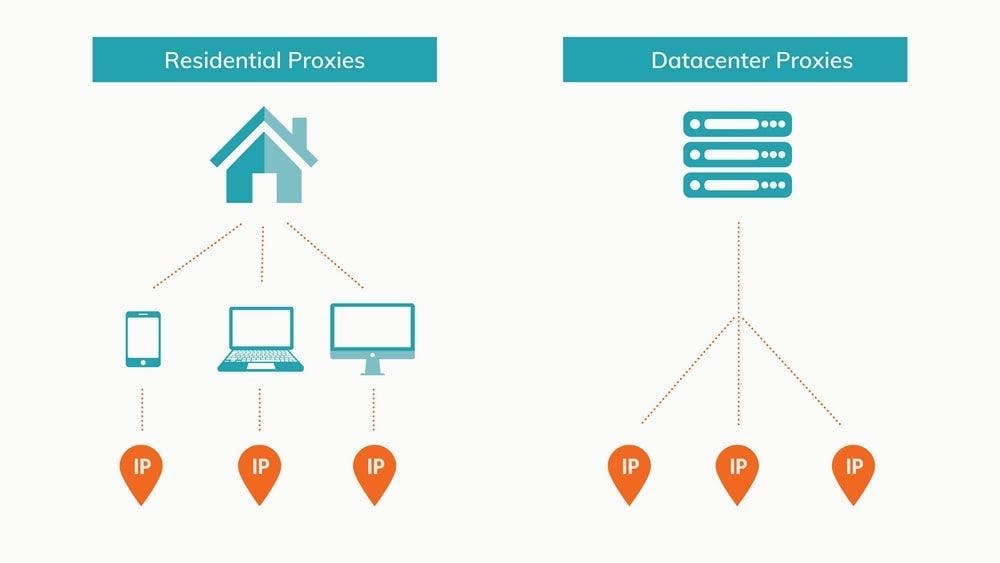

Centro de dados vs. Residencial

Há várias formas de classificar os proxies. Pode optar-se pelo anonimato, pelo acesso ou pela origem. Este último fator é o mais importante para os projectos de recolha de dados da Web. Nesse sentido, os proxies são geralmente de centro de dados ou residenciais. Vejamos cada um deles.

Rotação de proxies de centros de dados

Os centros de dados são assim designados devido à sua capacidade inigualável de armazenar e partilhar informações online. O termo "armazenado na nuvem" é apenas uma forma mais concisa de dizer "armazenado num centro de dados, e pode aceder-lhe desde que tenha Internet". A versão mais curta soa muito melhor.

Os centros de dados são essencialmente enormes colecções de servidores interligados com uma colossal capacidade de armazenamento combinada e a infraestrutura para os manter a funcionar. Os proxies de centros de dados, como já deve ter adivinhado, são alojados por estas estruturas. Para obter proxies, é necessário criar um servidor virtual, instalar nele um sistema operativo e, em seguida, instalar software especializado para configurar IPs como proxies.

A chave para proxies de datacenter eficientes é encontrar o equilíbrio correto de servidores e IPs. Um servidor pode conter vários IPs, mas cada um deles cria mais despesas gerais. Em algum momento, o retorno do servidor diminuirá e será necessário criar um novo. Fazer malabarismos com servidores e IPs dá muito trabalho, por isso a maioria dos programadores prefere alugar ou comprar estes proxies a empresas especializadas.

Os IPs não estão associados a um fornecedor de serviços Internet. Em vez disso, está a lidar com os proprietários do centro de dados ou com um terceiro que utiliza espaço de armazenamento para configurar proxies e distribuí-los aos clientes.

São uma escolha popular para os scrapers da Web porque:

- São baratos em comparação com os IPs residenciais devido à forma como são configurados em massa;

- A sua velocidade superior significa que pode recolher mais dados em menos tempo;

- São muito fiáveis graças à sólida infraestrutura dos centros de dados;

- É fácil comprar ou alugar em grandes quantidades a partir do mesmo parque de servidores.

Claro que tudo tem as suas desvantagens. No caso dos proxies para centros de dados, essas desvantagens são:

- Os seus IPs são mais fáceis de detetar por sítios Web vigilantes;

- Todos os proxies do mesmo centro de dados partilham um identificador de sub-rede, o que os torna mais propensos a proibições gerais.

- É mais difícil criar um pool de proxy com IPs de todos os países, uma vez que os centros de dados são em número reduzido.

Utilizando proxies de datacenters rotativos, é possível aceder e extrair com êxito a maioria dos sítios Web. Uma vez que cada novo pedido provém de um IP diferente, é relativamente difícil localizar e bloquear o scraper.

Os sítios Web avançados e populares são uma história diferente. A Amazon, o Google e outros nomes importantes enfrentam diariamente scrapers e outros bots. Como resultado, é muito mais provável que se note. Além disso, os proxies de centros de dados correm sempre o risco de já terem sido banidos, uma vez que todos os IPs do mesmo centro de dados partilham uma sub-rede.

O que mais importa é quem você escolhe como seu provedor de serviços de proxy e como eles gerenciam seus IPs. Por exemplo, os proxies do datacenter do WebScrapingAPI são privados e garantem pouca ou nenhuma lista negra.

Rotação de mandatários residenciais

Se os centros de dados são a alternativa nova e de alta tecnologia, os IPs residenciais são a opção experimentada e verdadeira. Os IPs residenciais são dispositivos reais ligados à Web através de um ISP. Estes proxies são praticamente indistinguíveis dos utilizadores normais porque, de certa forma, são apenas isso.

A configuração de um pool de proxy de datacenter requer algum conhecimento de CS, dinheiro e o software correto. Por outro lado, reunir IPs residenciais é muito mais complicado. Primeiro, teria de convencer as pessoas a deixarem-no instalar um software especializado no seu dispositivo que lhe dá acesso à distância. Depois, teriam de deixar as máquinas sempre ligadas. Caso contrário, o proxy seria por vezes inutilizável.

Devido ao incómodo e ao grau de confiança necessário, é extremamente fácil para os criadores alugar proxies residenciais a fornecedores de serviços dedicados.

Em comparação com os proxies de centros de dados, os IPs residenciais têm algumas vantagens importantes:

- Os IPs residenciais são apoiados por ISPs e parecem visitantes normais enquanto navegam na Web, tornando o scraper mais difícil de detetar;

- Cada IP é único, pelo que, mesmo que um proxy seja identificado e bloqueado, todos os outros continuam a poder ser utilizados;

- É mais fácil preparar um conjunto de proxies a partir de uma vasta gama de localizações, garantindo um acesso mais fácil a conteúdos com restrições geográficas.

Apesar destas vantagens substanciais que fazem dos proxies residenciais os melhores dos melhores em termos de eficácia, também têm alguns inconvenientes:

- Têm geralmente um custo mais elevado;

- Devido à localização e à ligação à Internet do dispositivo, a velocidade dos pedidos varia de IP para IP e é geralmente mais lenta do que a dos proxies de centros de dados;

- Tem de escolher cuidadosamente um fornecedor de proxy residencial, certificando-se de que oferece um bom número de IPs e que tem proxies nos países de que necessita para o seu projeto.

Os proxies residenciais, combinados com um sistema de rotação de IP e um script que faz o ciclo dos cabeçalhos dos pedidos (especialmente o agente do utilizador), proporcionam a melhor cobertura. Com isso, o seu raspador da Web pode recolher dados sem se deparar com barreiras, como bloqueios de IP ou CAPTCHAs.

Devido à sua autenticidade, os proxies residenciais são muitas vezes utilizados para a recolha de dados de sítios Web mais complexos, como motores de busca, grandes sítios de comércio eletrónico ou plataformas de redes sociais. No entanto, se iniciar sessão nestes sítios, desactive a rotação de proxy para que todos os pedidos provenham do mesmo IP. Caso contrário, parecerá que o mesmo utilizador está a enviar pedidos de todo o mundo numa questão de segundos, provando que se trata de um bot.

Porque é que deve utilizar proxies rotativos para a recolha de dados da Web

Alguns sítios Web tendem a ser alvos populares dos "web scrapers". Google, Amazon e Facebook são alguns exemplos. Estas plataformas esperam os bots, pelo que implementam métodos para os abrandar e impedir. Com o aumento da popularidade dos web scrapers, estas contramedidas estão a ser utilizadas por cada vez mais sítios Web.

Neste contexto, está a tornar-se cada vez mais vital rodar os seus IPs. Caso contrário, corre o risco de se deparar com constantes bloqueios de IP, captchas, e o seu grupo de proxy torna-se lentamente ineficaz.

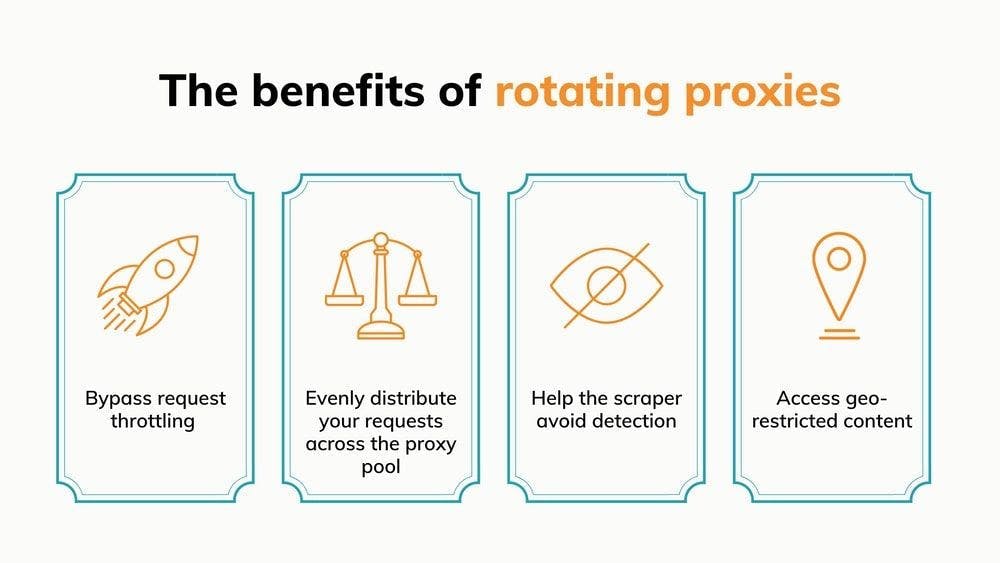

Ultrapassar a limitação dos pedidos

A limitação de pedidos é uma técnica através da qual os sítios Web diminuem a velocidade a que os bots podem navegar. Por outras palavras, limita o número de pedidos que um visitante pode fazer num determinado período de tempo.

Quando o limite é atingido, o bot é redireccionado para uma página CAPTCHA. Se a sua ferramenta de recolha de dados da Web não tiver capacidades de resolução de CAPTCHA ou se estas não funcionarem, o IP não pode continuar a recolher dados nesse sítio Web.

A principal conclusão aqui é que os sítios Web monitorizam o número de pedidos enviados de cada IP. Se os seus pedidos forem enviados de vários endereços, a carga é partilhada entre eles. Eis um exemplo:

Se um sítio Web estiver configurado de forma a que, após 10 pedidos, o 11.º pedido accione um CAPTCHA, isso significa que pode recolher 10 páginas antes de ter de parar e alterar manualmente o IP. Se estiver a recolher informações sobre preços, isso pode ser uma gota de água em comparação com o número total de páginas que pretende recolher.

Ao rodar os seus proxies, elimina a necessidade de intervir manualmente. Poderá fazer scraping dez vezes mais do que o número de proxies que tem. Depois, o único limite é o tamanho da pool de proxies, sendo cada IP utilizado em todo o seu potencial.

A melhor parte é que a limitação de pedidos limita o número de visitas durante um determinado período. Com um conjunto de proxies suficientemente grande, o temporizador para os proxies que já utilizou expirará antes de ter de os chamar novamente, dando-lhe capacidades de recolha de dados praticamente ilimitadas.

Distribuir uniformemente os pedidos pelo pool de proxy

Pela mesma lógica do ponto anterior, a rotação de proxy garante que não está a utilizar excessivamente os mesmos IPs enquanto outros ficam parados. Em termos mais básicos, está a utilizar os seus recursos da forma mais eficiente possível. O resultado - pode obter os mesmos resultados com um número menor de IPs.

Sem a rotação de proxies, está a utilizar o mesmo IP até este ser bloqueado, enquanto todos os outros proxies estão a ganhar pó. Quando um deixa de funcionar, passa-se para o seguinte. Este método faz com que os proxies pareçam um recurso finito que é utilizado para recolher dados. Isso não é necessário.

Com uma boa distribuição de localizações e de centros de dados/residências, um conjunto de proxies decente pode durar indefinidamente se rodar os IPs. Tudo o que precisa de ter a certeza é que nenhum proxy se destaca e corre o risco de ser bloqueado.

Na mesma linha, a rotação de proxy pode acelerar exponencialmente o processo de scraping. A chave aqui são os pedidos simultâneos. A maioria das APIs de raspagem da Web pode enviar vários pedidos simultaneamente, o número depende do pacote escolhido.

O envio de 50 pedidos ao mesmo tempo para o mesmo sítio Web é suscetível de levantar algumas bandeiras vermelhas. De facto, está tão longe do comportamento normal do utilizador que o mais provável é ser bloqueado imediatamente. Provavelmente consegue adivinhar onde isto vai dar. A rotação dos seus proxies é uma obrigação, pois permite-lhe levar o scraper ao limite sem ser bloqueado.

Ajudar o raspador a evitar a deteção

No que diz respeito ao bloqueio, uma das vantagens mais significativas dos proxies rotativos é o anonimato que garantem. Vamos lá a isso!

Os sítios Web não gostam muito de ser visitados por bots. Podem estar a tentar impedi-lo de recolher dados ou apenas a tentar garantir que nenhum programa malicioso está a tentar fazer cair os seus servidores. É por isso que implementam várias contramedidas para detetar e bloquear os bots. Como os web scrapers navegam na Internet mais rapidamente do que os utilizadores normais, destacam-se. Pense no exemplo com 50 pedidos simultâneos. De acordo com o ContentSquare's 2020 Digital Experience Benchmark, o utilizador médio passa 62 segundos numa única página. A diferença de comportamento é evidente.

Com os proxies rotativos, alterna constantemente entre IPs e evita enviar vários pedidos a partir de um único endereço. O resultado é que o sítio Web vê o tráfego que gera como um grupo de visitantes separados, sem qualquer ligação entre eles.

Aceder a conteúdos com restrições geográficas

Um rotador de proxy não deve apenas trocar IPs aleatoriamente. Claro que, por vezes, isso é suficiente, mas uma funcionalidade mais avançada que deve procurar é a opção de rodar proxies de uma região específica.

Esta caraterística é fundamental quando se está a tentar recolher informações que dizem respeito a uma única região. Dependendo da origem geográfica de um pedido, alguns sítios Web podem:

- Apresentar dados específicos da origem do IP

- Restringir o acesso porque o pedido provém de um país bloqueado

Assim, ao rodar um conjunto diversificado de proxies, pode atenuar as desvantagens e aproveitar as vantagens. Aplicado aos pontos anteriores, isso significa:

- Obter uma melhor visão geral dos mercados estrangeiros através da obtenção de dados específicos de vários países;

- Extrair informações que, de outra forma, estariam inacessíveis devido ao facto de determinados países estarem bloqueados no sítio Web.

É importante estar atento e reparar quando os sítios Web personalizam o seu conteúdo com base na origem do pedido. Estes sítios têm o potencial de oferecer excelentes informações sobre os dados de um país. No entanto, se não souber que está a receber informações personalizadas, pode acabar por ter imprecisões significativas nos seus dados.

Como utilizar proxies rotativos

Tal como os web scrapers, pode construir, gerir e utilizar um proxy rotator sozinho. Para isso, vai precisar de conhecimentos de programação (Python é o ideal, pois tem muitas estruturas valiosas e uma comunidade ativa), alguns conhecimentos gerais de CS, uma lista de proxies e muita paciência.

A forma mais básica seria um script que recebe uma variável contendo sua lista de proxy e atribui IPs aleatórios para cada solicitação. Por exemplo, você poderia usar a função random.sample() para escolher um IP completamente aleatório a cada vez, mas isso significa que o mesmo proxy pode ser usado várias vezes consecutivas. Nesse caso, você pode fazer com que, após um IP ser usado, ele seja retirado da lista de proxy, para que não seja usado novamente até que todos os outros endereços também sejam usados.

Aqui está um pequeno exemplo em Python:

import random

import requests

proxy_pool = ["191.5.0.79:53281", "202.166.202.29:58794", "51.210.106.217:443", "5103.240.161.109:6666"]

URL = 'https://httpbin.org/get'

while len(proxy_pool) >0:

random_proxy_list = random.sample(proxy_pool, k=1)

random_proxy = {

'http': 'http://' + random_proxy_list[0],

}

response = requests.get(URL, proxies=random_proxy)

print(response.json())

proxy_pool.remove(random_proxy_list[0])

O código só faz o ciclo do pool de proxy uma vez e o faz para um único URL, mas deve ilustrar bem a lógica. A propósito, eu peguei os IPs de https://free-proxy-list.net/. Sem surpresa, eles não funcionaram.

De facto, esse é o problema de construir o seu próprio rotador. Continuará a precisar de bons IPs dedicados ou, pelo menos, partilhados. Quando chegar ao ponto de comprar proxies, mais vale procurar uma solução que rode os IPs por si também. Desta forma, não gasta tempo extra a construí-la nem dinheiro extra a subcontratá-la. Além disso, obtém mais vantagens como:

- Uma opção rápida para rodar apenas IPs de uma região específica;

- A possibilidade de escolher o tipo de proxies a utilizar (datacenter ou residencial; regular ou móvel; etc.)

- Configurar IPs estáticos para quando se está a fazer scraping atrás de um ecrã de início de sessão;

- Novas tentativas automáticas com novos IPs quando um pedido falha.

Tomemos a WebScrapingAPI como exemplo de como é fácil fazer scraping de uma página com proxies rotativos. O código seguinte foi retirado diretamente da documentação, onde existem muitos outros snippets semelhantes:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us"

}

response = requests.request("GET", url, params=params)

print(response.text)

Este é todo o código necessário para extrair um URL ao usar proxies de datacenter dos EUA. Observe que não há uma lista de IPs para alternar ou mesmo um parâmetro para isso. Isso ocorre porque a API alterna os proxies por padrão. Se você quiser usar o mesmo IP para várias sessões, basta adicionar um novo parâmetro:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us",

"session":"100"

}

response = requests.request("GET", url, params=params)

print(response.text)

Basta utilizar o mesmo número inteiro para o parâmetro "sessão" para utilizar o mesmo IP estático para qualquer URL.

Os melhores fornecedores de proxy rotativo

Agora que já sabe como os proxies rotativos podem otimizar o processo de recolha de dados da Web, o próximo passo deve ser escolher um fornecedor de proxies que se adeqúe às suas necessidades e recursos. Compilei uma lista dos meus favoritos com base em vários factores diferentes: preços, localizações de proxy e o número de proxies de centros de dados e residenciais.

1. WebScrapingAPI

Deixe-me perguntar-lhe: o que é melhor do que obter proxies rápidos, eficientes e económicos para ligar ao seu raspador Web?

A resposta - obter uma API de raspagem da Web rápida, eficiente e acessível que faz tudo isso por si. Poderia continuar a falar sobre as funcionalidades de extração de dados da WebScrapingAPI, mas vamos concentrar-nos nos IPs por agora. O conjunto total de proxies tem mais de 100 milhões de IPs espalhados por todo o mundo.

Em vez de medir a utilização da largura de banda, pode escolher um pacote com um determinado número de chamadas à API. Cada chamada de API significa uma página raspada, cada uma através de um IP diferente, uma vez que, como mencionei, a rotação de proxy está activada por defeito.

Existem cinco pacotes à escolha, incluindo uma opção gratuita que lhe dá 1.000 chamadas API por mês (para além da avaliação gratuita) para formar a sua opinião sobre o produto. O preço começa em $20 para 200.000 chamadas de API, e as taxas melhoram para pacotes maiores. Para casos de utilização especiais, podemos trabalhar na criação de um plano personalizado que satisfaça as suas necessidades.

Se pretender extrair dados através de proxies de uma localização específica, tem bastantes opções. O conjunto de proxies do centro de dados está dividido entre 7 países, enquanto os IPs residenciais podem ser escolhidos entre 40 áreas diferentes. Se isso não for suficiente, pode optar por um pacote personalizado com a opção de adicionar 195 outras localizações à sua lista.

2. Oxylabs

A Oxylabs adoptou uma abordagem interessante com a rotação de IPs. Normalmente, quando escolhe um pacote, tem de rodar os IPs por si próprio, mas tem a opção de comprar também o seu rotador de proxy como um complemento.

Embora alguns casos de utilização possam não depender muito da rotação de proxies, esta é imperativa na extração de dados, por isso, se escolher proxies da Oxylabs, adquira também o rotador.

A empresa oferece pacotes separados para proxies residenciais e de datacenter. A utilização de IP residencial tem um preço baseado na largura de banda utilizada, com o plano mais baixo a começar em 300 dólares por mês para 20 GB de tráfego. Os proxies para centros de dados têm largura de banda ilimitada e os pacotes diferem no número de IPs que recebe. Estes começam em $160 por mês, e tem de escolher entre 100 IPs dos EUA ou 60 IPs de fora dos EUA.

No total, têm mais de 100 milhões de proxies residenciais e 2 milhões de proxies de centros de dados. Por isso, é pouco provável que fique sem IPs.

O conjunto de proxies está espalhado por uma área impressionante - 186 locais diferentes. Embora todos esses países tenham IPs residenciais, não espere que todos eles também tenham proxies de centros de dados.

3. Deslocador

O Shifter aproveita ao máximo a infraestrutura de ponta por trás dos proxies de datacenter. Como resultado, eles também oferecem proxies de datacenter compartilhados além da opção de IP dedicado que você espera.

Algo que gostamos na oferta do Shifter é o grande número de pacotes por onde escolher. Por exemplo, o plano de proxy partilhado mais pequeno começa em $30 por mês para aceder a 10 proxies partilhados. No outro extremo do espetro, pode obter 1000 proxies partilhados por $2000. Em suma, tem opções.

Os proxies dedicados de centros de dados são, previsivelmente, mais caros, com o pacote mais barato a começar em 25 dólares para 5 IPs a que só o utilizador tem acesso.

Se estiver interessado em IPs residenciais, os preços começam em 250 dólares por mês para 10 proxies backconnect especiais, o que significa que um servidor trata da rotação de proxies, para que não tenha de se preocupar.

O seu conjunto de proxies contém mais de 31 milhões de IPs, e os utilizadores podem ver o número exato no seu painel de controlo.

A segmentação geográfica está disponível para qualquer país do mundo, mas há uma ressalva - só pode ser utilizada com endereços IP residenciais.

4. SmartProxy

Além do seu impressionante conjunto de proxies, o SmartProxy vem com uma boa seleção de ferramentas. Estas são um gerador de endereços proxy, add-ons para Chrome e Firefox e um programa que o ajuda a navegar na Internet a partir de vários navegadores em simultâneo.

Mas voltemos aos proxies. A Smartproxy oferece aos seus utilizadores acesso a mais de 40 milhões de IPs residenciais, bem como a 40 mil proxies de centros de dados. Para além destes, também fornecem proxies residenciais únicos, concebidos para a recolha de dados dos motores de busca. Ao contrário das outras duas opções, cujo preço depende da largura de banda utilizada, os pacotes de proxy para motores de busca têm um número fixo de pedidos.

Embora a maioria dos IPs seja dos EUA, Reino Unido, Canadá, Alemanha, Índia e Japão, existem mais de cem locais com pelo menos 50 IPs.

Em termos de preço, está a olhar para pacotes que começam em $50 para 100 GB de tráfego através de proxies de centros de dados ou 75$ para 5 GB com proxies residenciais. Como seria de esperar, os planos mais alargados têm ofertas mais vantajosas.

5. Dados brilhantes

A Bright Data apresenta um impressionante conjunto de proxies composto por proxies de centros de dados, residenciais e móveis. Em números, é o seguinte:

- Mais de 700.000 IPs de centros de dados

- Mais de 72.000.000 de IPs residenciais

- Mais de 85.000 IPs residenciais estáticos

- Mais de 7.500.000 IPs móveis

É certo que são em grande número. A desvantagem é que os preços também são bastante elevados. Embora existam alguns pacotes com preços definidos, é melhor utilizar a calculadora de preços para criar um plano personalizado para si. Com esta calculadora, pode definir quantos IPs pretende e uma largura de banda máxima por mês, e receberá o preço exato.

Relativamente à geo-localização, a Bright Data tem IPs em praticamente todos os países do mundo. Têm uma página no seu sítio Web onde se pode verificar as localizações. Se precisar de certos tipos de proxies em áreas específicas, essa página será útil.

Como escolher um fornecedor de serviços proxy

Uma das vantagens mais significativas da raspagem da Web e dos proxies, em geral, é a riqueza de opções.

Como a maioria das pessoas ou empresas tem um objetivo específico em mente, não é invulgar escolher um fornecedor e depois perceber que não é adequado. Não é o ideal, mas acontece. Felizmente, a maioria das empresas tem um período experimental, um pacote gratuito ou, pelo menos, uma política de devolução do dinheiro.

Como tal, o melhor conselho que lhe posso dar é que explore as suas opções, veja as montras e encontrará certamente algo que seja adequado para si.

Para além de proxies, também vai precisar de um raspador da Web, certo? Bem, de todas as alternativas, aqui estão 10 produtos de extração de dados que merecem a sua atenção.

Se não tiver tempo, aqui fica uma recomendação resumida, só para si: inicie o seu teste gratuito do WebScrapingAPI e não precisará de experimentar outros scrapers!

Notícias e actualizações

Mantenha-se atualizado com os mais recentes guias e notícias sobre raspagem da Web, subscrevendo a nossa newsletter.

Preocupamo-nos com a proteção dos seus dados. Leia a nossa Política de Privacidade.

Artigos relacionados

Explore as complexidades da extração de dados de produtos da Amazon com nosso guia detalhado. De práticas recomendadas e ferramentas como a API Amazon Scraper a considerações legais, saiba como enfrentar desafios, contornar CAPTCHAs e extrair insights valiosos com eficiência.

Explore o poder transformador da recolha de dados da Web no sector financeiro. Desde dados de produtos a análises de sentimentos, este guia oferece informações sobre os vários tipos de dados da Web disponíveis para decisões de investimento.

Comparando Cheerio e Puppeteer para raspagem da Web? Caraterísticas, benefícios e diferenças cobertas. Dicas incluídas. Escolha a melhor ferramenta para si.